پیشرفت علم اعصاب برای هوش مصنوعی

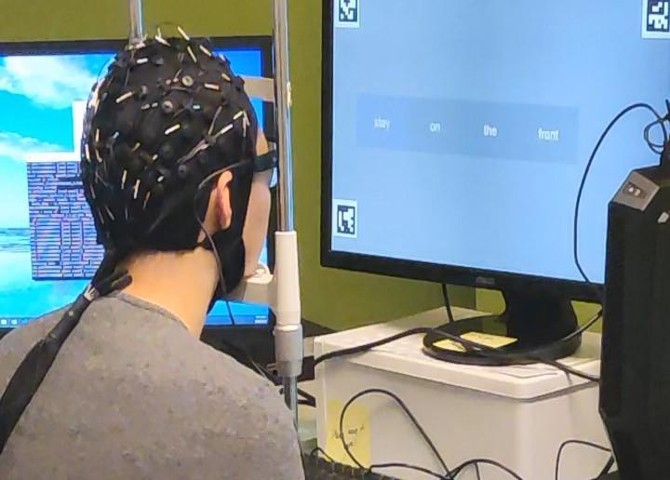

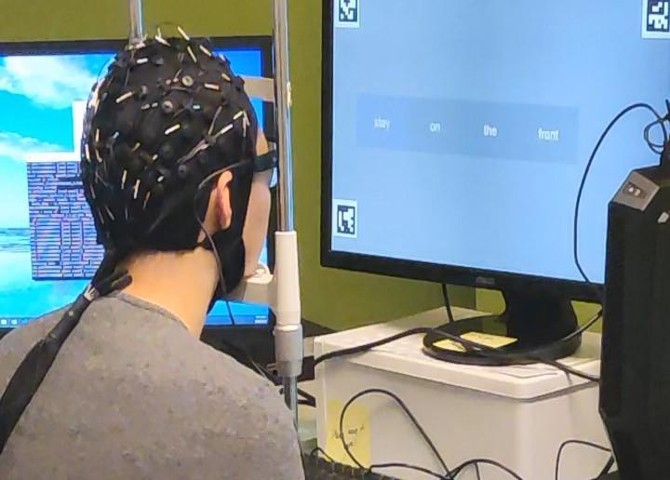

به گزارش علمی نیوز و به نقل از Psychology Today، ابتدا صفحه کلید، سپس لمس و صدا برای کنترل دستگاه ها و برنامه های محاسباتی وجود داشت. بعدش چی؟ محققان مؤسسه رفتار مغزی مورتیمر بی. زاکرمن در دانشگاه کلمبیا در شهر نیویورک با توسعه یک رابط مغز و کامپیوتر (BCI) که افکار انسان را با وضوح و دقت بالاتری نسبت به راه حل های موجود به گفتار تبدیل می کند، "اولین علمی" را اعلام کردند. . این تیم تحقیقاتی به سرپرستی دکتر نیما مسگرانی، یافتههای خود را در 29 ژانویه 2019 در مجله Scientific Reports ، یک مجله تحقیقاتی Nature منتشر کرد.

رابط مغز و کامپیوتر یک مسیر ارتباطی دو طرفه بین مغز و کامپیوتر است. بسیاری از پروژههای تحقیقاتی BCI بر روی استفاده از پروتزهای عصبی برای افرادی که حرکت، بینایی، شنوایی یا گفتار را از دست داده یا دچار اختلال شدهاند، مانند مواردی که تحت تأثیر سکته مغزی، آسیبهای نخاعی، اسکلروز جانبی آمیوتروفیک (ALS)، آفازی (اختلالات گفتاری ناشی از مغز) هستند، متمرکز شدهاند. آسیب)، آسیب حلزون، و سندرم قفل شده.

تا پیش از این پیشرفت، فرآیند رمزگشایی سیگنالهای مغزی از مدلهای محاسباتی سادهتری مبتنی بر رگرسیون خطی برای تجزیه و تحلیل نمایشهای بصری فرکانسهای صدا (طیفگرام) استفاده میکرد که گفتار نامفهومی تولید میکرد. مسگرانی و تیم تحقیقاتی او آخرین فناوریها در ترکیب گفتار را با یادگیری عمیق هوش مصنوعی ترکیب کردند تا درک گفتار بازسازیشده را بهبود بخشند و نتایج بهطور قابلتوجهی بهبود یافته است.

مسگرانی با جراح مغز و اعصاب اشش دینش مهتا، MD، Ph.D. در موسسه علوم اعصاب شرکای Northwell Health Physician شریک شد تا فعالیت مغزی بیماران صرع کانونی مقاوم به دارو را که قبلاً تحت عمل جراحی مغز قرار میگرفتند، اندازهگیری کند.

الکتروکورتیکوگرافی تهاجمی (ECoG) برای اندازهگیری فعالیت عصبی پنج شرکتکننده در مطالعه که همگی تواناییهای شنوایی طبیعی خود را گزارش کردند در حالی که به مدت نیم ساعت به چهار سخنران داستان کوتاه گوش میدادند، استفاده شد. الگوهای عصبی ضبطشده بهعنوان ورودی داده برای آموزش یک صداگذار، یک پردازشگر صوتی که صدای انسان را تجزیه و تحلیل و سنتز میکند، استفاده شد.

پس از آموزش رمزگذار صوتی، محققان سیگنالهای مغزی همان شرکتکنندگان را در حالی که به تعداد سخنرانان از صفر تا نه گوش میدادند، ضبط کردند. این سیگنالهای مغزی ثبتشده از طریق کد صوتی وارد میشد که به نوبه خود گفتار سنتز شده را تولید میکرد. در مرحله بعد، محققان از شبکه های عصبی مصنوعی برای اصلاح گفتار تولید شده توسط صداگذار استفاده کردند، سپس از 11 آزمودنی با شنوایی طبیعی به خروجی گوش دادند.

محققان دریافتند که استفاده از یک شبکه عصبی عمیق (DNN) با رگرسیون غیرخطی، درک را تا 67 درصد نسبت به روش پایه استفاده از رگرسیون خطی برای بازسازی طیفنگار شنوایی بهبود میبخشد. این شرکت کنندگان می توانستند صداهای تولید شده با ترکیب DNN-vocoder را با دقت 75 درصد درک کرده و تکرار کنند.

محققان یک چارچوب کلی پیدا کردند که می تواند برای فناوری های پروتز عصبی گفتار استفاده شود که می تواند به گفتار بازسازی شده دقیق و قابل فهم از قشر شنوایی انسان منجر شود. آنها تحقیقات خود را به عنوان "گامی به سوی نسل بعدی سیستم های تعامل انسان و کامپیوتر و کانال های ارتباطی طبیعی تر برای بیماران مبتلا به فلج و سندرم های قفل شده" می دانند.